釋放NPU潛能:SLM與異質整合協同設計下的混合AI架構轉型

摘要

隨著推論從雲端轉移至邊緣端,驅動小型語言模型(SLM)與硬體效能架構同步創新,形成混合AI運算模式。由於邊緣裝置受限於功耗與散熱條件,且推論速度取決於記憶體頻寬而非單純NPU算力,促使硬體朝異質整合架構發展,其中NPU以低功耗、高能效特性成為終端AI關鍵硬體;然而,目前多數AI模型仍以GPU優化,模型與硬體的協同設計將是發揮NPU效能的關鍵。

一. 代理AI將成AI走入現實生活應用的關鍵

二. 混合AI架構

三. 拓墣觀點

圖一 SLM輕量化技術分類說明

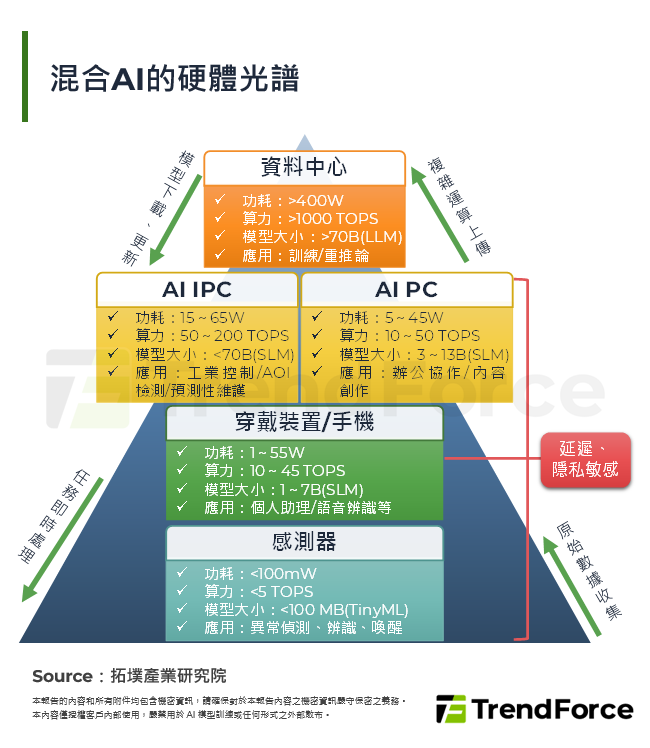

圖二 混合AI的硬體光譜

圖三 使用NPU執行的應用程式舉要

圖四 NPU推理效能優化的軟硬體協同架構

表一 SLM舉要

表二 各晶片廠商的NPU架構與API舉要