GPU針對AI Inference的Decode階段面臨的五大挑戰

摘要

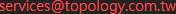

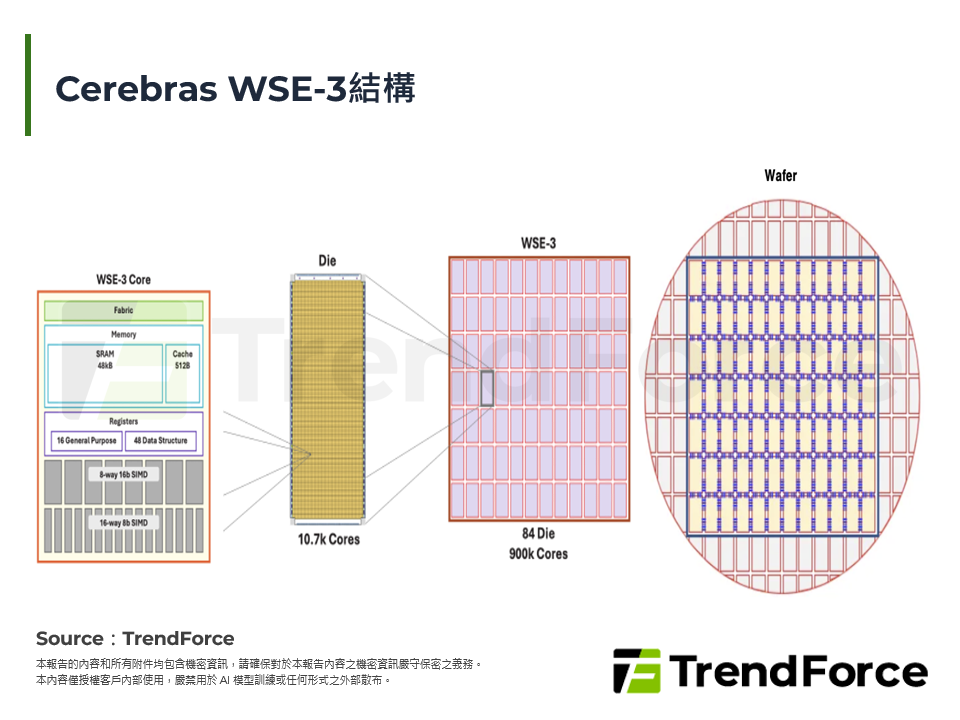

2025年12月24日NVIDIA以200億美元實質掌控Groq的智慧財產權與團隊,看中其以軟體為主設計、以SRAM為核心記憶體的Groq LPU在極低延遲Inference的表現;此外,NVIDIA也於CES 2026強調記憶體容量成為AI Inference的新瓶頸。為突破記憶體瓶頸,預計 GPU-for-Everything的時代將邁向終結,而異質化記憶體階層的新典範將展開。未來Hybrid Bonded SRAM、HBF皆成為AI晶片設計的潛在選項,以突破HBM在頻寬、延遲、容量上的限制。因此本篇報告主要深度解析:(1) Inference晶片設計要求;(2) Groq LPU/GroqRack技術解析;(3) HBM vs. HBF vs. HBSRAM比較;(4) Groq LPU對NVIDIA的戰略意義。期能為廠商與投資人解析Inference晶片要求、Groq LPU和HBSRAM的技術發展與未來可能性。